1. Généralités

ChatGPT est un exemple d'outil d'intelligence artificielle qui a été développé pour aider à la création de contenu automatisé en langage naturel. Il fonctionne sur la base de l'apprentissage automatique en utilisant des algorithmes pour analyser et comprendre les données d'entrée, puis génère des résultats précis en fonction des modèles qu'il a appris. Les outils d'intelligence artificielle comme ChatGPT peuvent être utilisés dans une variété de domaines, notamment la création de contenu et la traduction. Avec l'évolution rapide de la technologie, ces outils sont devenus de plus en plus accessibles, y compris pour les étudiants·es.

(S. Labrecque, échange avec l’agent conversationnel ChatGPT, 2 mars 2023. Modifiée et bonifiée par les membres du CIA.)

- Robot conversationnel : Programme informatique qui simule une conversation avec des êtres humains. Il utilise l'intelligence artificielle et le traitement du langage naturel pour comprendre et répondre aux messages des utilisateurs de manière interactive. (Ex. : ChatGPT, Bard, Mon IA de SnapChat)

- Générateur d'images : Modèle d'intelligence artificielle utilisé pour générer de nouvelles images réalistes. Il analyse un ensemble de données d'images existantes, identifie les motifs et les caractéristiques communes, puis génère de nouvelles images basées sur ces informations. (Ex. : DALL-E, MidJourney, Stable Diffusion)

- Outils de reconnaissance d'image : Programme informatique qui utilise des algorithmes d'apprentissage automatique pour identifier et classifier des objets, des personnes ou des motifs dans des images ou la recherche d'images. (Ex. : Google Image Recognition)

- Traducteur automatique : Outil qui utilise l'intelligence artificielle pour traduire du texte d'une langue à une autre de manière automatique. Ils peuvent être utiles pour la lecture de documents d’une autre langue et ainsi faciliter la compréhension de sources originales. (DeepLTranslate, Google traduction).

- Outils de reconnaissance vocale : Modèle d’intelligence artificielle qui convertit la parole en texte. Ils sont utilisés dans les systèmes de transcription automatique, les assistants vocaux et les applications de dictée.

- IA émotionnelle : Outil d'analyse de sentiment qui utilise le traitement du langage naturel pour déterminer les émotions et les opinions exprimées dans un texte. Peut être utilisé pour analyser les commentaires des étudiants, les opinions sur les sujets d'étude, ou pour effectuer des études de marché.

- Systèmes de recommandation : Programmes informatiques qui utilisent des algorithmes d'apprentissage automatique pour analyser les préférences et les comportements des utilisateurs, afin de leur recommander des produits, des services ou du contenu adapté à leurs intérêts. (Ex. : ALI)

- IA de programmation par les pairs : Logiciel autonome capable d’utiliser des modèles de langage avancés pour générer automatiquement des suggestions de code en temps réel. (Ex. : GitHub Copilot).

(M. Bouchard, échange avec l’agent conversationnel ChatGPT, 1e juin 2023. Modifié et bonifié par les membres du CIA.)

Il n’y a pas réellement de façons efficaces d’interdire ou d’empêcher l’utilisation des outils d’intelligence artificielle, autre qu’en classe avec un contrôle strict des appareils pouvant se connecter au réseau du cégep ou à un réseau personnel. De plus, il y a fort à parier que cette technologie sera présente de façon durable dans tous les aspects de la vie citoyenne, comme la calculatrice, Wikipédia ou les moteurs de recherche.

(Réseau REPTIC (2023), FAQ et synthèse : Agents conversationnels en pédagogie collégiale, Fédération des cégeps.)

2. Utilisations de l’IA en enseignement supérieur

Le sens critique et l’éthique prendront plus de place dans les programmes. La compréhension du fonctionnement d’un agent conversationnel, les biais induits par l’outil, l’impact écologique et l’utilisation efficace de cette technologie pourraient devenir des objets d’étude incontournables. La réflexion en équipe-programme sur les compétences de la formation générale et de la formation spécifique pouvant être porteur de ces savoirs en lien avec le profil de sortie des étudiants sera importante.

(Réseau REPTIC (2023), FAQ et synthèse : Agents conversationnels en pédagogie collégiale, Fédération des cégeps.)

De nombreux enseignants craignent que les systèmes d’IA diminuent leur rôle voire les remplacent à l’avenir, en raison de l’intensification de l’utilisation et de l’incidence de l’intelligence artificielle dans l’éducation. Plutôt que remplacer les enseignants, l’IA peut soutenir leur travail en leur permettant de concevoir des expériences d’apprentissage qui donnent aux apprenants les moyens d’être créatifs, de réfléchir, de résoudre des problèmes concrets, de collaborer efficacement, et de fournir des expériences d’apprentissage que les systèmes d’IA ne peuvent pas fournir à eux seuls. En outre, l’IA peut automatiser les tâches administratives répétitives, ce qui permet de consacrer plus de temps aux apprentissages. De cette façon, le rôle de l’enseignant est susceptible d’être renforcé et d’évoluer avec les capacités que les nouvelles innovations de l’IA dans l’éducation apporteront. Toutefois, cela nécessite une gouvernance rigoureuse du développement et de l’utilisation des applications d’IA, ainsi qu’une attention particulière au maintien de la capacité d’action de l’enseignant.

(European Commission, Directorate-General for Education, Youth, Sport and Culture, (2022). Lignes directrices éthiques sur l’utilisation de l’intelligence artificielle (IA) et des données dans l’enseignement et l’apprentissage à l’intention des éducateurs, Publications Office of the European Union, p13. https://data.europa.eu/doi/10.2766/420567 )

Avantages :

- Authenticité des apprentissages : L’utilisation des outils d’intelligence artificielle étant appelée à faire partie de notre quotidien, l’intégrer aux activités d’enseignement permet de faire vivre à l’étudiant des situations authentiques d’apprentissage.

- Acquisition de nouvelles connaissances: L'IA est un outil extrêmement puissant pour l'acquisition de nouvelles connaissances. Elle peut fournir des réponses rapides aux questions courantes des élèves sur une multitude de sujets puis approfondir ces mêmes sujets en posant des questions plus pointues.

- Développement de compétence dans la rédaction de demandes formulées à l'IA: L'interaction avec l'IA nécessite une certaine compétence pour formuler correctement les demandes. Il s'agit d'un processus d'apprentissage bidirectionnel où l'utilisateur apprend à mieux communiquer avec l'IA et cette dernière améliore continuellement ses réponses en fonction des requêtes de l'utilisateur.

- Synthétiser l'information: L'IA est capable de traiter de grandes quantités de données (articles de presse, comptes rendus de recherche, publications sur les réseaux sociaux, etc.) et d'en extraire l'information pertinente. L’IA relève les modèles et les tendances trouvées puis les présente ensuite à l’utilisateur.

- Développer un esprit critique sur l'IA: Pour comprendre les avantages, les limites et les implications éthiques des outils d’IA, il est essentiel de les étudier et de les utiliser. Les enseignants et les étudiants pourront alors prendre des décisions en toute connaissance de cause sur les enjeux de vie privée, de sécurité, d’équité, d’environnement, etc. relatifs à l’IA.

- Approche pédagogique personnalisées et adaptées: Les outils d’IA peuvent analyser les performances, les préférences d’apprentissage et les progrès des élèves, puis proposer des exercices et des recommandations adaptés à leur niveau et leurs intérêts. Ils peuvent également fournir un retour d'information précis et spécifique à chaque élève, favorisant ainsi l'amélioration continue. (exemple : Wooflash )

Risques :

- Fiabilité des informations : Les réponses fournies par un robot conversationnel peuvent être inexactes ou biaisées. Les images ou les documents audiovisuels produits par IA peuvent aussi induire les gens en erreur.

- Manque de discernement : Les outils d’IA sont limités dans leur capacité à évaluer la validité et la crédibilité des informations. Ils peuvent répondre à n'importe quelle question, qu'elle soit factuelle, subjective ou même trompeuse, sans pouvoir faire preuve de discernement. Cela peut entraîner une propagation d'informations erronées ou non vérifiées auprès des élèves.

- Manque d'interaction humaine : L’IA ne peut pas établir des liens émotionnels ni comprendre pleinement les besoins de chaque élève.

- Obstacle à l’acquisition de connaissances : Il y a un risque de démotivation des étudiants·es quant à l’acquisition de connaissances déclaratives s’il y a une croyance qu’on peut toujours se fier aux agents conversationnels.

- Obstacle à l’obtention de compétences : Déléguer systématiquement des tâches à l’IA pourrait limiter ou carrément empêcher l’apprentissage de certaines connaissances ou aptitudes de base. Sans ces bases, le développement de certaines compétences plus complexes pourrait être difficile voire impossible et porter atteinte au cheminement pédagogique de l’élève.

(M. Bouchard, S. Labrecque, échanges avec l’agent conversationnel ChatGPT, mai 2023. Modifiés et bonifiés par les membres du CIA.)

Les outils d’IA peuvent faciliter la création de matériel didactique pour le personnel enseignant. Par exemple, les agents conversationnels peuvent être utilisés pour :

- Rédiger un plan de cours en fonction de compétences ou de contenus spécifiques;

- Élaborer un examen;

- Proposer des activités à réaliser en classe;

- Rédiger des questions et des consignes pour les évaluations;

- Suggérer des améliorations à une production initiale;

- Explorer des genres textuels dans l’élaboration de consignes;

- Accélérer la classification et la catégorisation de l’information;

- Créer des résumés;

- Vulgariser par l’adoption d’une posture particulière (âge, emploi, etc.);

- Simuler des questions d’entrevue;

- Proposer des problèmes en situation authentique dans un domaine donné.

Cependant, la validité de l’information doit toujours être vérifiée par triangulation des sources.

(Réseau REPTIC (2023), FAQ et synthèse : Agents conversationnels en pédagogie collégiale, Fédération des cégeps. Modifié et bonifié par les membres du CIA.)

Les limites des outils d’IA sont différentes pour chacun d’entre eux. À titre d’exemple, l’utilisation de ChatGPT comporte les limites suivantes :

- Actuellement, ChatGPT ne peut répondre à aucune question sur des faits survenus après 2021, puisque sa base de données a été extraite du web cette année-là.

- Il est programmé pour refuser de répondre à certaines demandes inappropriées (par exemple donner des instructions pour commettre un acte illégal).

- Il peut commettre des erreurs factuelles. Il ne fait que générer la séquence de mots la plus probable pour répondre à une requête, il n’est pas capable d’en évaluer la validité.

- Il ne cite pas ses sources, ou le fait parfois incorrectement.

- Il reproduit les biais présents dans sa base de données.

- Il a des connaissances limitées sur certains sujets plus pointus.

- Bien qu’il génère des textes originaux, il ne fait pas preuve de créativité à proprement parler. Il ne va pas au-delà des contenus existants, il imite des styles.

(Université du Québec en Abitibi-Témiscamingue. (2023). ChatGPT et les outils d’intelligence artificielle : quelles implications pour l’enseignement? UQAT ressources pédagogiques. https://enseigner-soutien.uqat.ca/ressources/chatgpt )

3. Enjeux

Quels sont les aspects que je dois considérer avant d’utiliser les outils d’IA avec les étudiants?

Certains faits sont à considérer avant d’utiliser des outils d’IA. Les conditions d’utilisation sont spécifiques à chaque plate-forme; il convient donc à l’utilisateur de prendre connaissance de celles-ci avant d’en faire usage. Dans certains cas :

- Les outils d’IA ont la plupart du temps un âge minimal d’utilisation.

- Les informations personnelles sont souvent conservées et peuvent être transmises à des partis tiers.

- L’utilisateur est souvent responsable des entrées qu’il soumet et de l’utilisation des extrants qui demeurent la propriété des plates-formes d’IA.

- Les conditions d’utilisation peuvent parfois être changées à tout moment sans obligation à en informer les utilisateurs.

- L’utilisation de ces outils doit être faite en respect des droits fondamentaux et non dans une intention malveillante.

- Dans un contexte de publication d’un produit généré par l’IA, il y a obligation de distinguer les apports respectifs de l’utilisateur et de l’outil d’IA.

À qui appartient le contenu généré par les outils d’IA? Remarque : cette réponse ne peut pas être considérée comme un avis légal, pour des informations propres à votre situation ou votre juridiction, vous devez consulter un avocat spécialisé en propriété intellectuelle.

Le statut juridique du contenu généré par une IA est un sujet complexe et en évolution, car les lois n'ont pas encore pleinement assimilé les implications juridiques de cette technologie.

Voici cependant quelques principes généraux qui peuvent s'appliquer :

- L'IA n’est pas une entité juridique capable d'être l'auteur d'une œuvre.

- Le contenu généré par l’IA n’est pas considéré comme une œuvre originale par la loi au Canada.

- Les contrats et les accords entre les parties peuvent jouer un rôle significatif dans la détermination de la propriété du contenu généré par une IA.

Comment citer l’utilisation de l’IA?

Au même titre que toute autre source qui a été utilisée dans le cadre de la production d’un travail, il est nécessaire de mentionner lorsque vous utilisez ou modifiez du texte généré par l’IA. Voici plusieurs cas de figure, selon vos besoins :

Télécharger la version PDF de l'infographie.

Qu’advient-il de la désinformation et des biais de l’IA?

Les IA génératives ont la capacité de produire des affirmations parfois fausses et biaisées, ce qui augmente les risques de désinformation et de discrimination envers certains groupes. Lorsque l'algorithme ou les données sur lesquelles une IA apprend contiennent des erreurs ou des biais, elle peut reproduire les données erronées et renforcir les préjugés et les stéréotypes. Il sera donc important de vérifier méticuleusement les informations recueillies à l’aide d’une IA.

(QUÉBEC. COMMISSION DE L’ÉTHIQUE EN SCIENCE ET EN TECHNOLOGIE. « Les enjeux éthiques et pédagogiques de l’utilisation des intelligences artificielles génératives en enseignement supérieur. », 2023, https://ethique.gouv.qc.ca/fr/projets-en-cours/les-enjeux-ethiques-et-pedagogiques-de-l-utilisation-des-intelligences-artificielles-generatives-en-enseignement-superieur/ (Page consultée le [29 juin 2023]))

Qu’en est-il de l’autonomie au regard des savoirs?

Les IA génératives posent un risque pour les étudiants, car il est difficile de contrôler les connaissances qu'elles utilisent. Les contenus générés par ces IA sont incorporés dans des modèles prédictifs qui sont souvent difficiles à comprendre. Ce problème de manque de transparence peut empêcher les étudiants et étudiantes d'accéder aux informations et aux connaissances qui correspondent le mieux à leurs préférences et à leurs objectifs personnels, ce qui nuit à leur autonomie.

(Commission de l’éthique en science et en technologie (2023). Les enjeux éthiques et pédagogiques de l’utilisation des intelligences artificielles génératives en enseignement supérieur. https://ethique.gouv.qc.ca/fr/projets-en-cours/les-enjeux-ethiques-et-pedagogiques-de-l-utilisation-des-intelligences-artificielles-generatives-en-enseignement-superieur/. Remaniée avec l’aide de ChatGPT.)

L’intelligence artificielle représente-t-elle nécessairement un risque d’inégalité des chances à la réussite scolaire?

L’IA peut donner lieu à de nouvelles formes d’inégalités ou de discrimination et exacerber celles qui existent déjà. Toutefois, si elle est conçue et utilisée correctement, elle peut également améliorer l’accès et l’inclusion au quotidien, au travail et dans l’éducation. L’IA peut également fournir des ressources éducatives aux jeunes personnes handicapées ou ayant des besoins particuliers. Par exemple, les solutions basées sur l’IA telles que le sous-titrage en temps réel peuvent aider les personnes souffrant d’une déficience auditive, de même que l’audiodescription peut rendre l’accès plus facile et plus efficace aux personnes ayant des troubles de la vue.

(European Commission, Directorate-General for Education, Youth, Sport and Culture, (2022). Lignes directrices éthiques sur l’utilisation de l’intelligence artificielle (IA) et des données dans l’enseignement et l’apprentissage à l’intention des éducateurs, Publications Office of the European Union, p.12. https://data.europa.eu/doi/10.2766/420567)

Comment s’assurer de l’égalité en matière d’apprentissage et d’évaluation ? Assurer l'égalité de réussite et d'apprentissage dans une salle de classe avec l'utilisation d'outils d'intelligence artificielle (IA) peut être atteint en mettant l'accent sur les stratégies et les mesures suivantes :

- Équipements et accès à Internet : Il est primordial que tous les élèves aient un accès équitable aux outils d'IA. Cela signifie avoir à leur disposition des appareils adéquats et une connexion Internet fiable, indépendamment de leur situation socioéconomique. Les établissements d’enseignement pourraient envisager un système de prêt d'équipement ou la mise en place de zones d'accès à Internet.

- Formation en IA pour les élèves : Les élèves devraient recevoir une formation sur l'utilisation efficace des outils d'IA. Cela comprend à la fois le fonctionnement technique de ces outils, mais également leur impact sociétal et éthique. En développant une compréhension critique de l'IA, les élèves peuvent mieux interagir avec ces technologies.

- Surveillance de l'utilisation de l'IA : Les enseignants devraient surveiller l'utilisation de l'IA en classe pour s'assurer qu'elle est utilisée de manière équitable et non discriminatoire. Cela comprend le respect des règles de confidentialité et de protection des données.

- Utilisation d'outils d'IA inclusifs : Il est essentiel que les outils d'IA utilisés en classe soient conçus de manière à prendre en compte une variété de besoins d'apprentissage. Par exemple, ils devraient comporter des fonctionnalités qui les rendent accessibles aux élèves ayant des handicaps ou des difficultés d'apprentissage.

En résumé, tout en exploitant le potentiel de l'IA pour améliorer l'enseignement et l'apprentissage, les enseignants et les établissements d’enseignement doivent veiller à adopter des stratégies qui garantissent que ces technologies sont utilisées de manière à promouvoir l'égalité des chances pour tous les élèves.

(S. Labrecque, échange avec l’agent conversationnel ChatGPT, 23 mai 2023. Modifiée et bonifiée par les membres du CIA.)

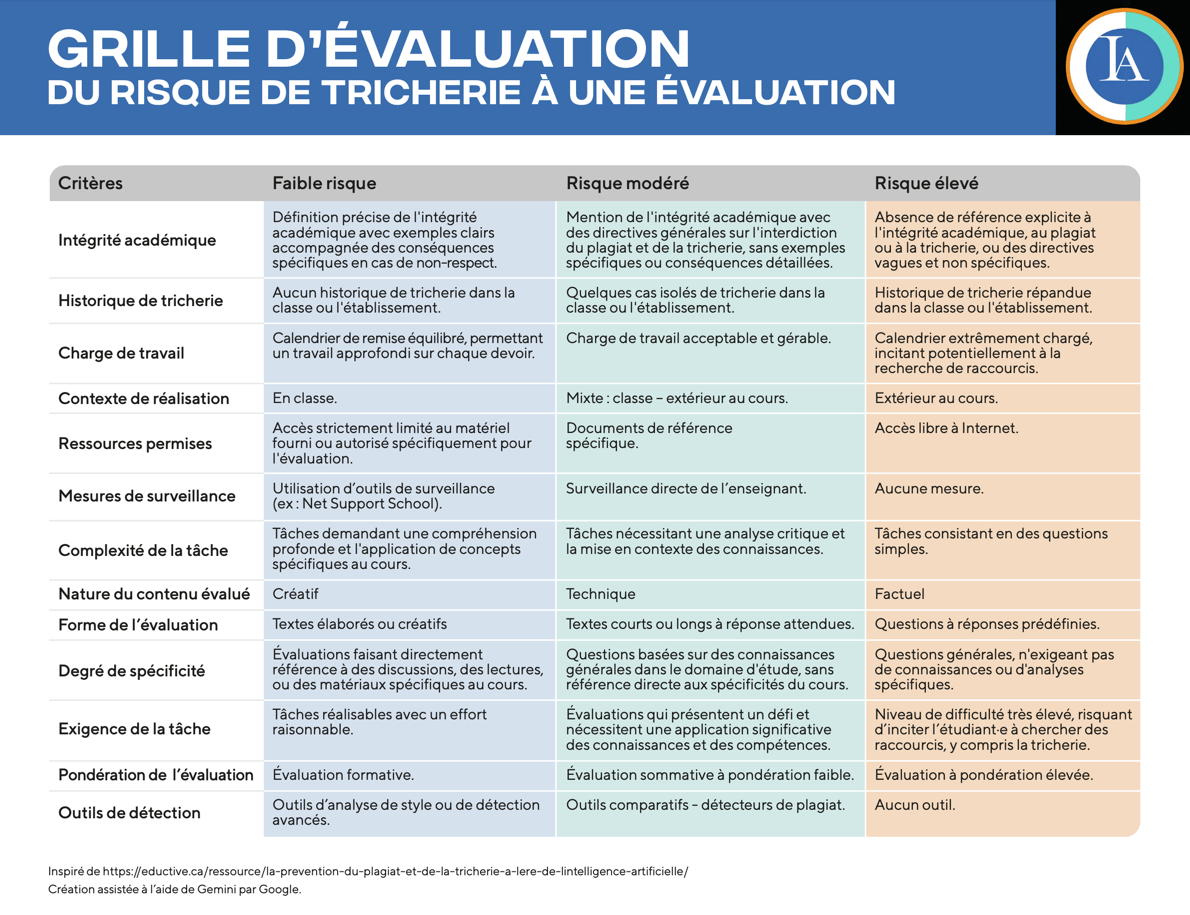

Quels sont les risques que mes étudiants·es aient recours aux outils d’IA pour tricher dans leurs examens et travaux de fin de session?

Avec l'accessibilité croissante des outils d'intelligence artificielle, il est possible que certains·es étudiants·es cherchent à les utiliser pour tricher dans leurs examens et travaux de fin de session. Les risques sont nombreux et comprennent la possibilité d’utiliser ChatGPT pour :

- Obtenir des réponses automatisées à des questions d’examen ou à celles d’un devoir;

- Générer des travaux de fin de session non originaux en copiant des parties de texte ou des paragraphes complets à partir de sources en ligne;

- Améliorer des travaux existants en utilisant des traductions précises et des reformulations des phrases fournies par ChatGPT.

Ces pratiques malhonnêtes pourraient potentiellement entraîner des conséquences négatives sur l’éthique scolaire et la qualité des apprentissages. Il est donc important que les enseignants·es soient conscients·es de ces risques et prennent des mesures pour limiter leur impact.

(S. Labrecque, échange avec l’agent conversationnel ChatGPT, 2 mars 2023. Modifiée et bonifiée par les membres du CIA.)

Que puis-je faire en tant qu'enseignant·e pour limiter les risques que mes étudiants·es trichent avec l'aide de ChatGPT dans leurs examens et travaux de fin de session?

En tant qu'enseignant·e, il est important de prendre des mesures pour limiter les risques de tricherie des étudiants·es à l'aide de ChatGPT dans leurs examens et leurs travaux de fin de session. Voici quelques mesures que vous pouvez prendre :

Lors de la planification des évaluations :

- Concevez des évaluations qui ne peuvent pas être facilement modifiées en utilisant ChatGPT, comme des questions qui nécessitent une réflexion personnelle ou une analyse approfondie plutôt que de simples réponses factuelles.

- Formulez des questions qui se rapportent à une image, un schéma ou un dessin.

- Adaptez les modalités de réponses en demandant de produire des schémas ou des représentations visuelles des informations demandées.

- Prévoyez tenir compte des 3P dans vos critères d’évaluation:

- Processus : évaluez les étapes et les stratégies utilisées par les apprenant·es pour atteindre les objectifs d'apprentissage. Demandez-leur de conserver des preuves de leur démarche.

- Produit : évaluez les résultats ou les performances des apprenant·es à la fin d'un processus d'apprentissage.

- Propos : évaluez la signification et la pertinence de l'apprentissage pour les apprenant·es ainsi que leur compréhension de la démarche réalisée et de leur travail.

Avant les évaluations et les travaux :

- Informez les étudiants·es des risques et des conséquences de la tricherie en leur expliquant que l'utilisation d'outils d'intelligence artificielle pour la tricherie est considérée comme une violation des règles scolaires.

- Sensibilisez les étudiants·es aux enjeux liés à l'éthique et à la propriété intellectuelle.

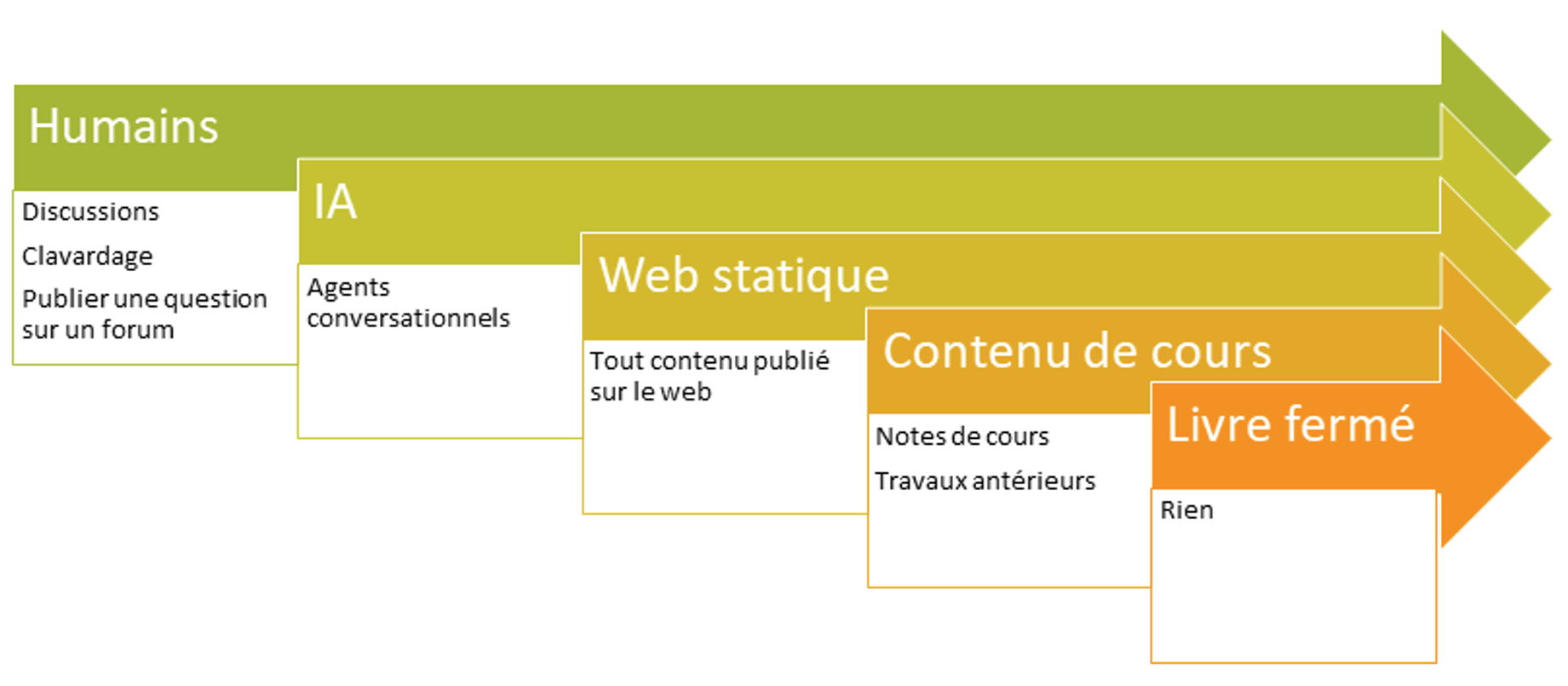

- Soyez explicite sur les règles qui entourent l'utilisation ou non des outils d'intelligence artificielle dans le cadre de l'évaluation demandée.

- Peuvent-ils y avoir recours ?

- Quelles sont les utilisations qui sont permises ?

- De quelle façon doivent-ils identifier cette source ?

En classe :

- Limitez l'utilisation des téléphones portables pendant les évaluations.

- Privilégiez les examens écrits au format papier-crayon pour décourager la tricherie et l'utilisation de ressources en ligne.

- Encouragez les étudiants·es à faire référence aux éléments vus en classe plutôt qu'à des sources disponibles sur Internet pour évaluer leur compréhension du cours.

- Pour les travaux à réaliser sur ordinateur, utilisez des applications de gestion de classe telles que Net Support School (voir Centre TIC) pour superviser les sessions et éviter la tricherie.

Pour la correction :

- Utilisez des outils tels que AI Text Classifier pour détecter les travaux qui ont été générés avec l'aide de ChatGPT. Cela permettra d’évaluer l'authenticité du travail et de favoriser l'intégrité scolaire. Bien que ces outils ne soient pas infaillibles, ils peuvent aider à apprécier la production fournie par l’étudiant.

(S. Labrecque, échange avec l’agent conversationnel ChatGPT, 2 mars 2023. Modifiée et bonifiée par les membres du CIA.)

4. Outils d’encadrement

Le plagiat et la tricherie (PIEA 6.3.8)

Lors d’une activité d’évaluation sommative, toute tentative de plagiat ou de tricherie (p. 8 PIEA) ou toute collaboration à un plagiat ou à une tricherie sont interdites, considérées comme des fraudes scolaires (p. 8 PIEA) et passibles de sanctions graves. La fraude scolaire est signalée au responsable de la coordination départementale et au Service de l’organisation scolaire qui est responsable du traitement des cas, de leur archivage et de l’application des sanctions.

Exemple de plagiat et de tricherie :

S’approprier les mots, paraphraser ou résumer les idées de quelqu’un d’autre sans le citer correctement et en indiquer la source et ce, peu importe le support sur lequel ces mots ou ces idées ont été diffusés :

- copier et coller ou recopier textuellement un ou des passages;

- insérer des images, graphiques, données chiffrées, vidéos, etc.;

- remettre un travail copié d’un autre étudiant (avec ou sans l’accord de celui-ci);

- présenter le même travail dans plus d’un cours ou lors de la reprise d’un même cours sans avoir obtenu au préalable l’autorisation des enseignants concernés;

- utiliser l’intelligence artificielle sans autorisation.

S’il s’agit d’une première, deuxième ou troisième infraction au cours de la formation de l’étudiant(e), le service concerné a la responsabilité de juger de la gravité de l’infraction et de la sanction qui en découle.

Première infraction |

Un premier acte de plagiat ou de tricherie entraîne la note 0 (zéro) pour l'activité d'évaluation des apprentissages concernée. |

Deuxième infraction |

En cas de récidive, l'étudiant(e) se verra attribuer la remarque « EC » (échec) pour le cours en cause. |

Troisième infraction |

La sanction peut aller jusqu’au renvoi temporaire ou définitif de l’étudiant(e). |

Tous les étudiant(e)s impliqué(e)s dans l’acte frauduleux sont passibles des mêmes sanctions.

Exemple 1

L’utilisation des agents conversationnels d’intelligence artificielle (IA)

Les étudiants qui utilisent l'IA sans autorisation peuvent être soumis à des sanctions disciplinaires. Son utilisation pour les travaux et les examens est donc interdite, à moins d’une autorisation de la part de l’enseignant, auquel cas, des consignes seront clairement expliquées et justifiées.

Pour chaque travail, les règles d'utilisation de l'IA seront communiquées par l'enseignant avant le début du travail et les étudiants doivent se conformer à ces règles.

Exemple 2 :

L’utilisation des agents conversationnels d’intelligence artificielle (tels que ChatGPT)

Il est permis d’utiliser les agents conversationnels dans la réalisation de certains travaux. Veuillez-vous référer aux énoncés des activités d’évaluation afin de connaître le degré d’utilisation permis dans ceux-ci.

Toute production (texte, code, image, etc.) ayant été générée partiellement ou totalement à l’aide d’agents conversationnels doit être clairement identifiée comme telle. Pour savoir comment indiquer qu’une production a été réalisée à l’aide d’agents conversationnels, référez-vous à « Présenter un travail scolaire ».

Exemple 1 :

Degrés d’utilisation intelligence artificielle

- Utilisation interdite : Les étudiants·es ne sont pas autorisés à utiliser des outils automatisés avancés (comme l'intelligence artificielle ou les outils d'apprentissage automatique tels que ChatGPT ou Dall-E 2) pour les devoirs dans ce cours / ce travail.

- Utilisation uniquement avec autorisation préalable : Les étudiants·es sont autorisés à utiliser des outils automatisés avancés (comme l'intelligence artificielle ou les outils d'apprentissage automatique tels que ChatGPT ou Dall-E 2) pour les devoirs dans ce cours / ce travail à condition qu’une autorisation préalable de l'enseignant·e est obtenue.

- Utilisation uniquement avec mention. Les étudiants·es sont autorisés à utiliser des outils automatisés avancés (comme l'intelligence artificielle ou les outils d'apprentissage automatique tels que ChatGPT ou Dall-E 2) pour les devoirs dans ce cours /ce travail si cette utilisation est correctement documentée et créditée. Par exemple, un texte généré à l'aide de ChatGPT doit inclure une citation telle que : (OPENAI. « Robot conversationnel expliqué », dans ChatGPT [intelligence artificielle], 1e juin 2023, https://openai.com/blog/chatgpt/). Les matériaux générés à l'aide d'autres outils doivent suivre une convention de citation similaire.

- Utilisation librement autorisée sans mention Les étudiants·es sont autorisés à utiliser des outils automatisés avancés (comme l'intelligence artificielle ou les outils d'apprentissage automatique tels que ChatGPT ou Dall-E 2) pour les devoirs dans ce cours / ce travail ; aucune documentation spéciale ou citation n'est requise.

(DIONNE, Bernard. L’essentiel pour réussir ses études, 2e édition, Montréal, Chenelièrere éducation, 2023, p.157)

(GUIDRY, Kevin R. « Considerations for using and addressing advanced automated tools in coursework an assignments », dans University of Delaware, https://ctal.udel.edu/advanced-automated-tools/#syllabus-language (Page consultee le [29 juin 2023]). Traduit par ChatGPT)

Échelle de correction – évaluation de la qualité d’utilisation de l’intelligence artificielle dans le cadre d’un travail.

Nécessite d’exiger la remise des traces de la démarche utilisée avec l’IA (processus) en plus du travail (produit) et d’évaluer la compréhension par l’étudiant·e (propos)(3P).

Degré |

Description |

Exceptionnel 90-100% |

Maîtrise de la réflexion critique sur le contenu généré par l'IA ; démontre la capacité à abstraire du matériel, à établir des relations non évidentes et à étendre de manière productive le matériel source ; preuve solide d'une pensée originale et d'une compréhension approfondie. Peut servir de modèle pour surpasser le contenu généré par l'IA. |

Excellent 80-89% |

Réflexion critique perspicace sur le contenu généré par l'IA ; améliorations convaincantes ; certaines pensées originales ; preuve claire que le niveau de compréhension dépasse celui des contributions synthétisées. Dans l'ensemble, une amélioration significative par rapport au contenu synthétisé par l'IA. |

Bon 70-79% |

Réflexion critique sur le contenu généré par l'IA ; tentatives généralement réussies pour l'améliorer ; preuve que le matériel a été essentiellement compris. Des améliorations importantes au-delà de la qualité du contenu généré par l'IA pourraient être réalisées. |

Satisfaisant 60-69% |

L'utilisation du contenu généré par l'IA nécessite une réflexion plus critique ; les tentatives d'amélioration doivent être plus convaincantes ; tout le matériel ne semble pas avoir été compris. Il existe évidemment une marge importante pour améliorer au-delà de la qualité du contenu généré par l'IA. |

Marginal 50-59% |

Utilisation non réfléchie du contenu généré par l'IA ; les tentatives pour l'améliorer sont incohérentes; manque de preuves que le matériel est compris. À peine supérieur à la qualité du contenu généré par l'IA. |

Insatisfaisant moins de 50% |

Ne montre aucune amélioration significative par rapport au contenu généré par l'IA. |

(STEIPE, Boris, dir. The Sentient Syllabus Project, http://sentientsyllabus.org (Page consultée le [29 juin 2023] Traduit par Chat GPT et adapté par les membres du CIA.)